C’è un momento, quando si parla di intelligenza artificiale, in cui la tecnologia smette di essere solo un insieme di algoritmi e diventa qualcosa di profondamente umano. È quel momento in cui ci chiediamo: “possiamo farlo?”, ma anche “dobbiamo farlo?”.

Negli ultimi anni Microsoft ha fatto di questa domanda un principio guida, costruendo intorno all’AI una struttura di valori e regole che non parlano di codice, ma di responsabilità. Si chiama Responsible AI e non è uno slogan: è un modo di progettare, testare e usare l’intelligenza artificiale che mette al centro le persone.

L’inizio: l’AI che guarda oltre il risultato

Nel 2016, quando l’AI stava diventando la nuova corsa all’oro del tech, Microsoft fondò un piccolo gruppo interno chiamato Aether (AI, Ethics and Effects in Engineering and Research).

L’obiettivo era semplice e ambizioso: garantire che ogni progetto di intelligenza artificiale venisse valutato non solo in termini di efficacia, ma anche di impatto etico e sociale.

Era un cambio di prospettiva: non più “cosa può fare l’AI”, ma “quali conseguenze può avere sulle persone”. Da lì nacque un framework che oggi guida ogni team dell’azienda: i sei principi della Responsible AI.

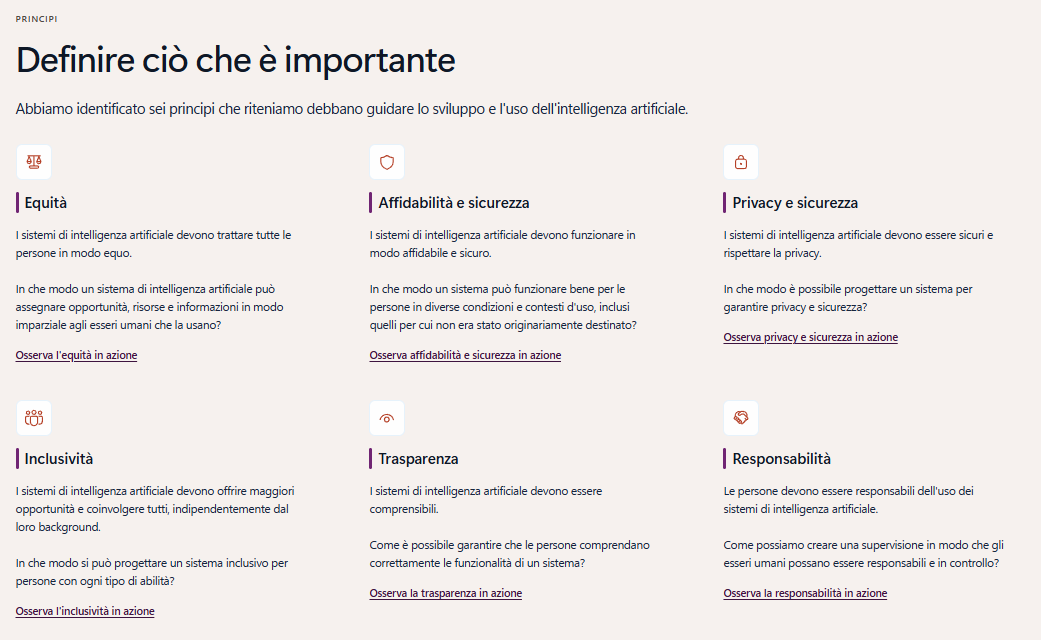

Figura 1: I sei principi della Responsible AI

I sei principi della Responsible AI

- Fairness (Equità)

L’AI deve trattare tutti in modo equo. Sembra ovvio, ma non lo è: un sistema di riconoscimento facciale, ad esempio, può identificare correttamente un volto maschile caucasico il 99% delle volte, ma sbagliare più spesso con persone di etnie diverse. Per questo Microsoft ha creato strumenti di audit per rilevare e correggere i bias nei dataset, e ha limitato l’uso del riconoscimento facciale in ambiti pubblici. - Reliability and Safety (Affidabilità e Sicurezza)

Un’AI deve funzionare in modo sicuro, soprattutto quando prende decisioni che toccano la vita reale. Nei progetti di AI per la sanità, ad esempio, Microsoft ha introdotto protocolli simili a quelli dell’ingegneria aerospaziale: ogni algoritmo viene “stressato” in simulazioni estreme prima di essere usato sul campo. - Privacy and Security (Riservatezza e Sicurezza dei dati)

Il rispetto della privacy è un pilastro: l’AI non deve sapere più del necessario. Strumenti come Microsoft Purview e Azure Confidential Computing garantiscono che i dati sensibili restino cifrati anche durante l’elaborazione, una frontiera che fino a pochi anni fa sembrava impossibile. - Inclusiveness (Inclusione)

L’AI deve essere accessibile e utile per tutti. Da qui nascono strumenti come Seeing AI, un’app gratuita che descrive il mondo a chi non può vederlo, o Immersive Reader, che aiuta studenti con dislessia a leggere testi più facilmente. Non si tratta solo di tecnologia, ma di empatia digitale. - Transparency (Trasparenza)

Gli utenti devono capire come e perché una macchina prende una decisione. Microsoft incoraggia la creazione di “model cards”: schede tecniche che spiegano in linguaggio chiaro come un modello è stato addestrato, con quali dati e quali limiti ha. È un po’ come leggere l’etichetta di un alimento: sapere cosa c’è dentro cambia il modo in cui lo consumi. No? - Accountability (Responsabilità)

Nessuna macchina è “autonoma” al punto da essere irresponsabile. Ogni decisione dell’AI deve avere un responsabile umano identificabile. In Microsoft, ogni team che sviluppa o integra AI deve seguire un processo di revisione chiamato RAI Review (Responsible AI Review), dove esperti di etica, legali e ingegneri discutono rischi e mitigazioni prima del rilascio.

Dalla teoria alla pratica: esempi concreti

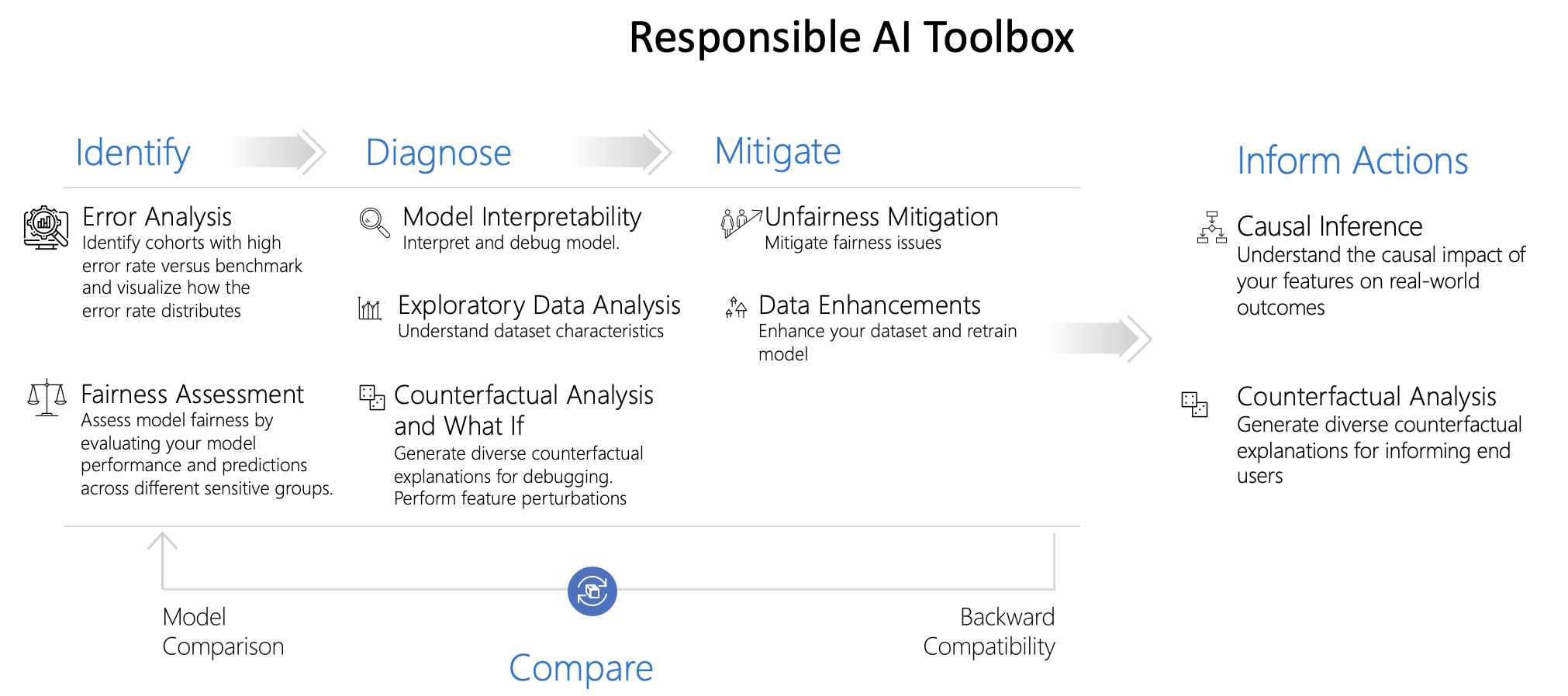

Figura 2: Il Responsible AI Toolbox di Microsoft: un insieme di strumenti open source che aiuta data scientist e sviluppatori a identificare, diagnosticare e mitigare bias e problemi di equità nei modelli di intelligenza artificiale, migliorandone la trasparenza e l’affidabilità.

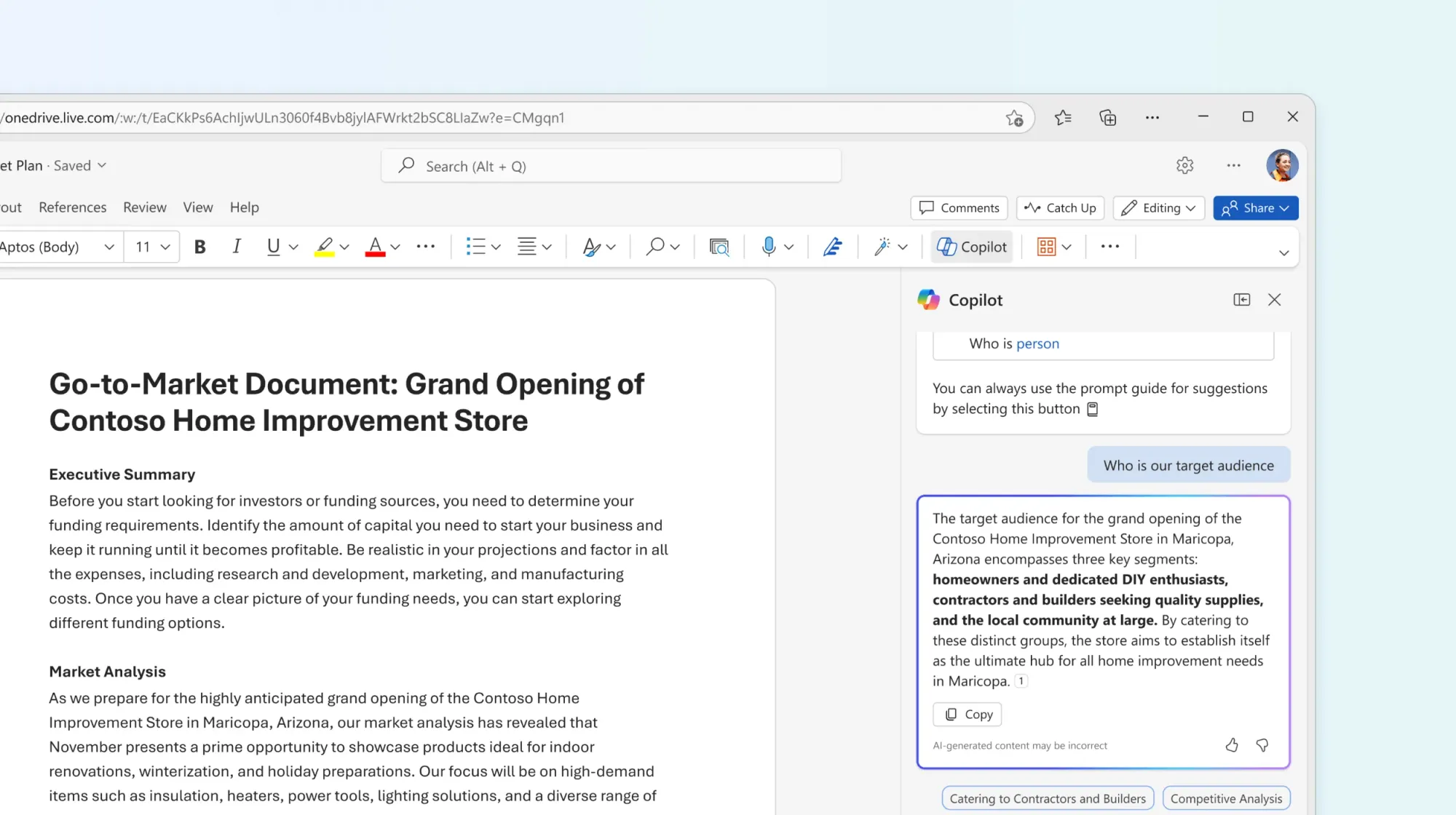

Uno degli esempi più emblematici arriva da Copilot, l’assistente di Microsoft 365. Copilot propone bozze e suggerimenti all’interno di Word, Excel, Outlook e Teams, ma è progettato per collaborare con l’utente umano, che ha sempre il compito di rivedere, integrare e approvare i contenuti.

Come spiega Microsoft nella Nota sulla trasparenza per Microsoft 365 Copilot, le risposte sono generate da modelli linguistici e si basano sui dati aziendali accessibili tramite Microsoft Graph.

Per questo, Microsoft raccomanda di verificare sempre le informazioni, citare le fonti quando disponibili e mantenere il controllo umano sul risultato finale.

L’obiettivo non è sostituire il giudizio, ma amplificarlo in modo responsabile, chiarendo capacità, limiti e buone pratiche d’uso.

Figura 3: Utilizzo di Microsoft 365 Copilot in Word

Altro caso: il progetto AI for Earth utilizza l’intelligenza artificiale per affrontare le grandi sfide ambientali. Grazie alla piattaforma Azure e agli strumenti di AI messi a disposizione da Microsoft, scienziati e startup possono analizzare dati ambientali su scala globale, esplorare modelli complessi e ottenere insight prima impensabili. Il programma supporta in particolare le aree agricoltura, acqua, biodiversità e cambiamento climatico.

Tra i vantaggi offerti ci sono l’accesso a risorse cloud avanzate, la capacità di processare enormi quantità di immagini e dati satellitari in tempi ridotti, e la messa a disposizione di strumenti open-source e API per ridurre la barriera all’ingresso.

In questo modo il progetto non solo aiuta a individuare problemi ambientali prima che diventino emergenze, ma consente anche di scalare le soluzioni in modo rapido e collaborativo, riducendo costi, tempo e complessità.

Figura 4: Analisi del rischio di deforestazione

Infine, in ambito pubblico, Microsoft ha scelto di non vendere tecnologie di riconoscimento facciale a forze dell’ordine finché non esisteranno leggi chiare sull’uso etico di questi strumenti.

Una decisione che, all’epoca, ha fatto discutere, ma che oggi viene vista come un segno di coerenza.

Perché l’etica non è un limite, ma un acceleratore

C’è chi pensa che mettere troppi vincoli all’intelligenza artificiale rallenti l’innovazione.

In realtà, succede il contrario: l’etica crea fiducia, e la fiducia accelera l’adozione. Le aziende, i cittadini, le scuole sono più inclini a usare strumenti AI quando sentono che dietro c’è un pensiero, non solo una tecnologia.

Un’AI “responsabile” è quella che sa dire anche no. Che rinuncia a una funzione rischiosa, che spiega un errore, che chiede conferma prima di agire. E in questo senso, forse, l’etica non è solo una bussola per chi progetta le macchine, ma una lezione per chi le usa.

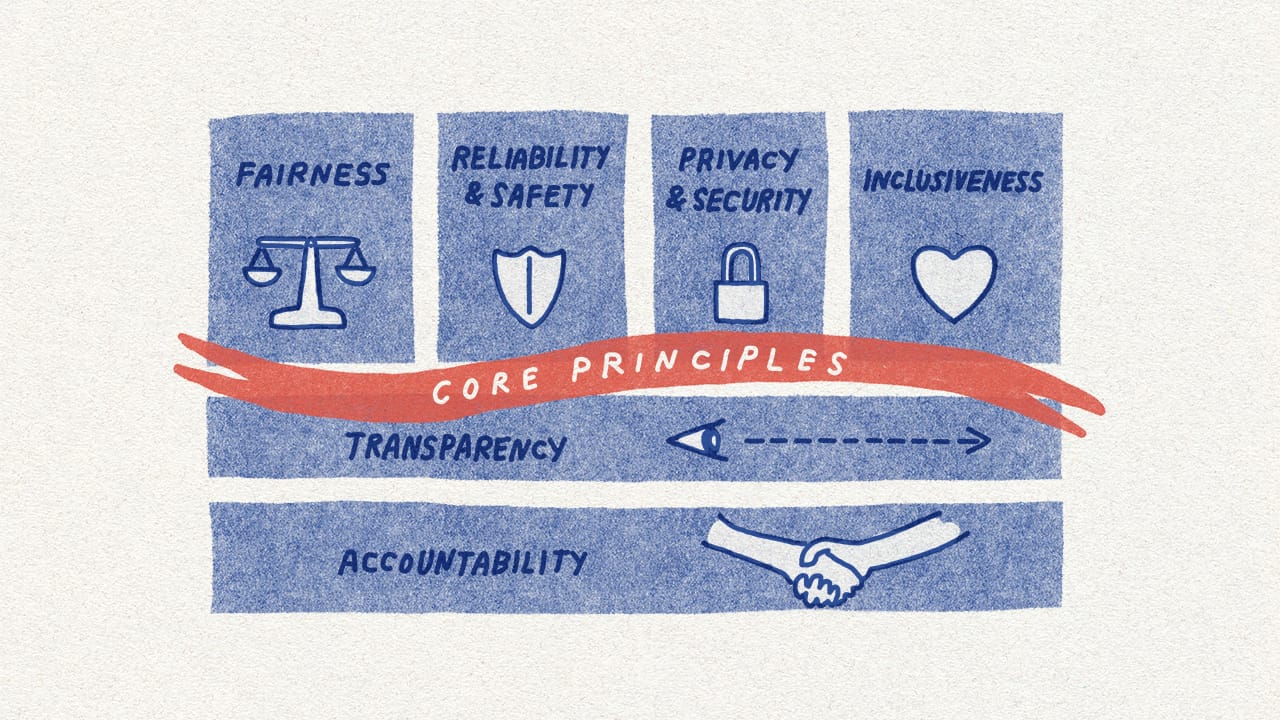

Figura 5: Grafica illustrativa del framework di Microsoft per costruire sistemi AI responsabili: principi, requisiti, pratiche; un’etica progettata non come freno ma come guida all’innovazione

Uno sguardo al futuro

Il futuro dell’intelligenza artificiale non sarà fatto solo di modelli più grandi e veloci, ma di modelli più giusti.

Microsoft continua a investire in questo equilibrio, collaborando con università, governi e organizzazioni per definire standard globali di AI responsabile.

L’obiettivo è ambizioso: far sì che ogni algoritmo, in ogni contesto, rifletta i valori della società che lo usa.

Come ha scritto Satya Nadella, CEO di Microsoft:

“L’intelligenza artificiale più potente non è quella che imita l’uomo, ma quella che amplifica il suo potenziale — in modo etico, inclusivo e sicuro.”

Figura 6: Responsible AI Transparency Report

Conclusione

Parlare di etica nell’intelligenza artificiale non significa frenare il progresso. Significa guidarlo, perché la tecnologia più avanzata non è quella che fa tutto da sola, ma quella che ci aiuta a fare meglio, insieme.

E forse, tra tutte le forme d’intelligenza, questa è la più umana.

Risorse e letture consigliate

- Microsoft Responsible AI Resource Center

- Embrace responsible AI principles and practices - Training | Microsoft Learn

- Responsible AI: Ethical policies and practices | Microsoft AI

- AI for Earth – Programma ufficiale Microsoft

- Responsible AI Transparency Report | Microsoft

- Copilot for Microsoft 365: guida e linee etiche di utilizzo

Discussioni